L'Analyse des Logs : Comprendre les Secrets des Robots des Moteurs de Recherche

Dans le monde numérique, la visibilité est synonyme de succès. Si vous voulez être remarqué, vous devez être visible, en particulier sur les moteurs de recherche. C’est là que l’analyse des logs entre en jeu. Avec elle, vous pouvez plonger profondément dans les interactions entre les robots des moteurs de recherche et votre site. Mais pourquoi est-ce si crucial, et comment cela fonctionne-t-il ? Découvrons-le ensemble.

La magie cachée derrière les Logs de votre Serveur

Les logs de serveur sont comme un journal intime pour votre site web. Ils enregistrent chaque demande, chaque visite et chaque interaction. Pour un œil non averti, ils peuvent ressembler à une série de chiffres et de lettres sans signification. Mais pour ceux qui savent les interpréter, ils révèlent les secrets des interactions entre votre site et les robots des moteurs de recherche.

Pourquoi devrions-nous prêter attention aux robots des moteurs de recherche ?

Ces robots, souvent appelés “crawlers” ou “spiders"🕷, parcourent le web, indexant chaque page qu’ils trouvent. Ils déterminent comment, où et quand votre site apparaît dans les résultats de recherche. Examinons plus en détail les raisons pour lesquelles nous devrions les surveiller de près :

1. Décrypter leurs mouvements : En scrutant les logs, on peut déchiffrer les pages que les robots visitent, à quelle fréquence, et quelles parties de votre site les intéressent le plus. Cela peut révéler des zones de votre site qui nécessitent une attention particulière ou des améliorations.

2. Gérer le budget de crawl : Chaque moteur de recherche a une limite de pages qu’il parcourt sur votre site lors d’une visite. En comprenant leur comportement, vous pouvez adapter votre site pour s’assurer que les pages cruciales sont priorisées.

3. Garder un œil sur les indésirables : Malheureusement, tous les robots ne sont pas vos amis. Certains peuvent avoir des intentions malveillantes. En surveillant de près les logs, vous pouvez repérer ces intrus et prendre des mesures pour les éloigner.

Python et l’analyse des logs : Un duo incontournable pour maîtriser les secrets du SEO

La compétition dans le monde numérique est rude. Pour se démarquer, il est essentiel de comprendre comment les moteurs de recherche interagissent avec nos sites web. C’est ici que l’analyse des logs prend tout son sens. Et quand il s’agit d’analyse, Python est un allié de taille. Plongeons ensemble dans la manière dont Python peut révolutionner votre approche de l’analyse des logs.

Python : Le langage de choix pour la data

Python, avec sa simplicité, sa flexibilité et sa vaste bibliothèque de modules, est devenu le langage de prédilection pour l’analyse des données. Mais qu’est-ce qui le rend si spécial pour l’analyse des logs ?

Simplicité : Python est réputé pour sa lisibilité et sa syntaxe claire, ce qui le rend facile à apprendre et à utiliser, même pour les débutants.

Polyvalence : Avec des bibliothèques comme Pandas, NumPy et Matplotlib, Python transforme l’analyse et la visualisation des données en une tâche aisée.

Performance : Python peut gérer d’énormes volumes de données avec une relative facilité, ce qui est essentiel lors de l’analyse de grands fichiers logs.

Décortiquer les Logs avec Python

Les logs de serveur, bien que riches en informations, peuvent sembler chaotiques. Python, avec ses bibliothèques spécialisées, peut aider à :

Filtrer les données : Extraire les informations pertinentes des logs, comme les visites des robots des moteurs de recherche, est simplifié avec Python.

Analyser les tendances : Vous souhaitez savoir à quelle fréquence un certain robot visite votre site ? Ou quelles pages sont les plus explorées ? Python peut vous fournir ces insights en quelques lignes de code.

Visualiser les résultats : Avec des outils comme Matplotlib ou Seaborn, visualiser vos données devient un jeu d’enfant. Transformez des milliers de lignes de logs en graphiques informatifs.

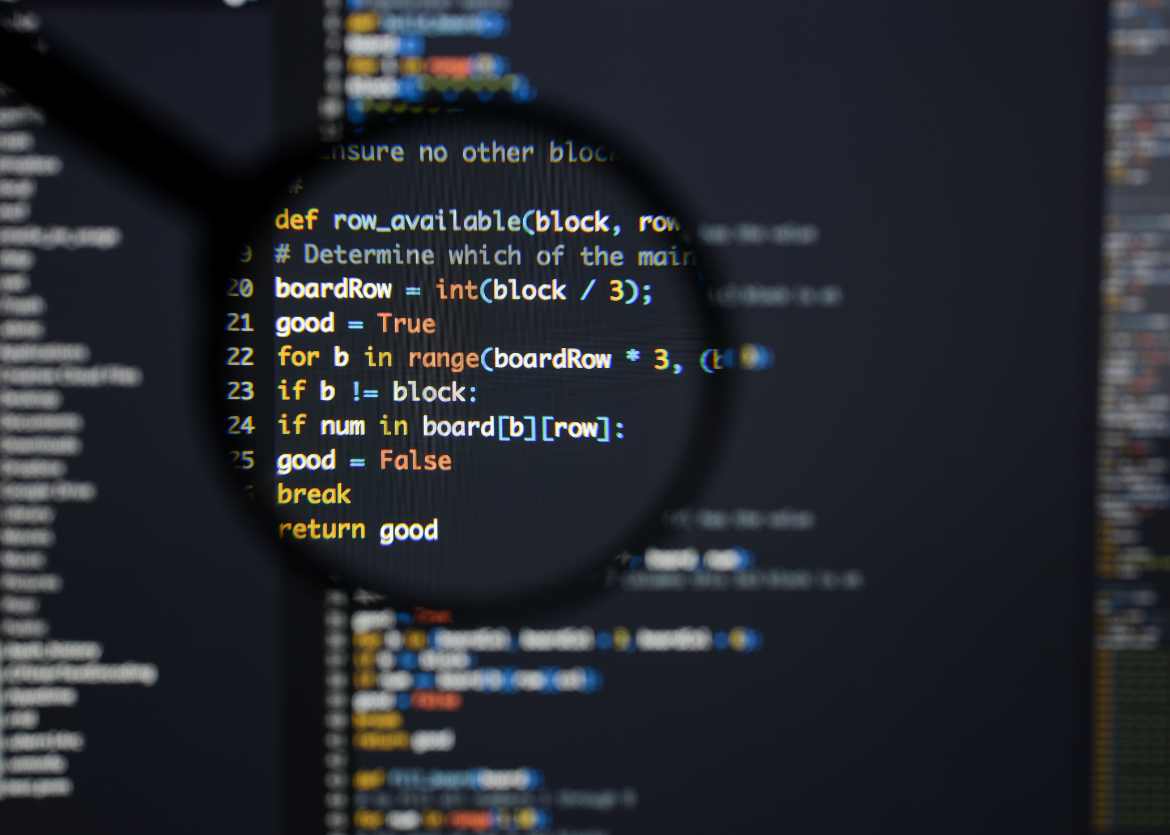

Le script ci-dessus en est un excellent exemple. Il utilise la puissance des expressions régulières pour identifier les visites de robots et compte leurs requêtes.

import re

from collections import defaultdict

import csv

# File paths

log_file_path = "access.log"

output_csv_path = "detailed_bots_requests_with_dates_updated.csv"

# Define patterns for bots

bots_patterns = {

"Googlebot": re.compile(r'Googlebot', re.I),

"Bingbot": re.compile(r'Bingbot', re.I),

"Yahoo! Slurp": re.compile(r'Yahoo! Slurp', re.I),

"DuckDuckGo": re.compile(r'DuckDuckBot', re.I),

"Baidu": re.compile(r'Baiduspider', re.I),

"Yandex": re.compile(r'YandexBot', re.I),

"AhrefsBot": re.compile(r'AhrefsBot', re.I),

"Majestic": re.compile(r'MJ12bot', re.I),

"SEMrush": re.compile(r'SemrushBot', re.I),

"AdsBot-Google": re.compile(r'AdsBot-Google', re.I),

"BLEXBot": re.compile(r'BLEXBot', re.I),

"PetalBot": re.compile(r'PetalBot', re.I),

"Snapchat": re.compile(r'Snapchat', re.I),

"SeekportBot": re.compile(r'SeekportBot', re.I),

"Applebot": re.compile(r'Applebot', re.I),

"Pulno": re.compile(r'Pulno', re.I),

"Others": re.compile(r'bot|crawl|spider|archiver', re.I)

}

# Initialize data structures

bots_counts = defaultdict(int)

bots_dates = defaultdict(lambda: {"first": None, "last": None})

# Process log file

with open(log_file_path, "r", encoding="utf-8", errors="ignore") as f:

for line in f:

date_match = re.search(r'\[(\d+/[a-zA-Z]+/\d+):', line)

date = date_match.group(1) if date_match else None

user_agent = re.search(r'\"([^\"]+?)\"$', line)

agent = user_agent.group(1) if user_agent else ''

matched_bot = next((bot for bot, pattern in bots_patterns.items() if pattern.search(agent)), None)

if matched_bot:

bots_counts[matched_bot] += 1

if not bots_dates[matched_bot]["first"] or date < bots_dates[matched_bot]["first"]:

bots_dates[matched_bot]["first"] = date

if not bots_dates[matched_bot]["last"] or date > bots_dates[matched_bot]["last"]:

bots_dates[matched_bot]["last"] = date

# Export the data to a CSV file

with open(output_csv_path, "w", newline="") as csv_file:

writer = csv.writer(csv_file)

writer.writerow(["Bot", "Number of Requests", "First Date", "Last Date"])

for bot, count in bots_counts.items():

writer.writerow([bot, count, bots_dates[bot]["first"], bots_dates[bot]["last"]])

print(f"Data exported to {output_csv_path}")

Ce script Python est conçu pour analyser un fichier de logs d’accès à un serveur web et extraire des informations sur les activités des bots d’exploration tels que les moteurs de recherche et autres crawlers. Voici comment le script fonctionne étape par étape :

1- Importation des modules nécessaires :

- `re`: Module pour les expressions régulières, utilisé pour rechercher des motifs dans le texte.

- `defaultdict`: Une variante de dictionnaire qui permet de définir des valeurs par défaut pour les clés.

- `csv`: Module pour la manipulation des fichiers CSV (Comma-Separated Values).

2- Définition des chemins de fichiers :

- `log_file_path`: Chemin du fichier de logs d'accès.

- `output_csv_path`: Chemin du fichier CSV de sortie contenant les informations détaillées sur les bots.

3- Définition des motifs pour détecter les bots :

- Les motifs sont définis sous forme de dictionnaire où les clés sont les noms des bots et les valeurs sont des expressions régulières correspondant aux noms des bots.

- Chaque expression régulière est insensible à la casse (utilisation de `re.I`).

4- Initialisation des structures de données :

- `bots_counts`: Un dictionnaire par défaut pour stocker le nombre de requêtes faites par chaque bot.

- `bots_dates`: Un dictionnaire par défaut où chaque bot a un autre dictionnaire avec les dates de la première et de la dernière requête.

5- Traitement du fichier de logs :

- Le fichier de logs est ouvert en mode lecture.

- Pour chaque ligne dans le fichier, le script recherche une correspondance pour extraire la date et l'agent utilisateur (user agent) à partir de la ligne.

- Le code utilise des expressions régulières pour extraire ces informations.

6- Détection du bot :

- Le script parcourt les motifs de bots définis et vérifie si l'agent utilisateur extrait de la ligne correspond à l'un des motifs.

- Si une correspondance est trouvée, le nom du bot est enregistré.

7- Mise à jour des données des bots :

- Si un bot est identifié, le compteur de requêtes pour ce bot est augmenté.

- Les dates de la première et de la dernière requête pour le bot sont mises à jour si les dates sont antérieures ou postérieures aux dates précédemment enregistrées.

8- Exportation des données vers un fichier CSV :

- Le script ouvre un fichier CSV en mode écriture.

- Il écrit une ligne d'en-tête dans le fichier CSV.

- Pour chaque bot et ses données associées, le script écrit une ligne dans le fichier CSV.

9- Affichage d’un message de fin :

- Le script affiche un message indiquant que les données ont été exportées vers le fichier CSV de sortie.

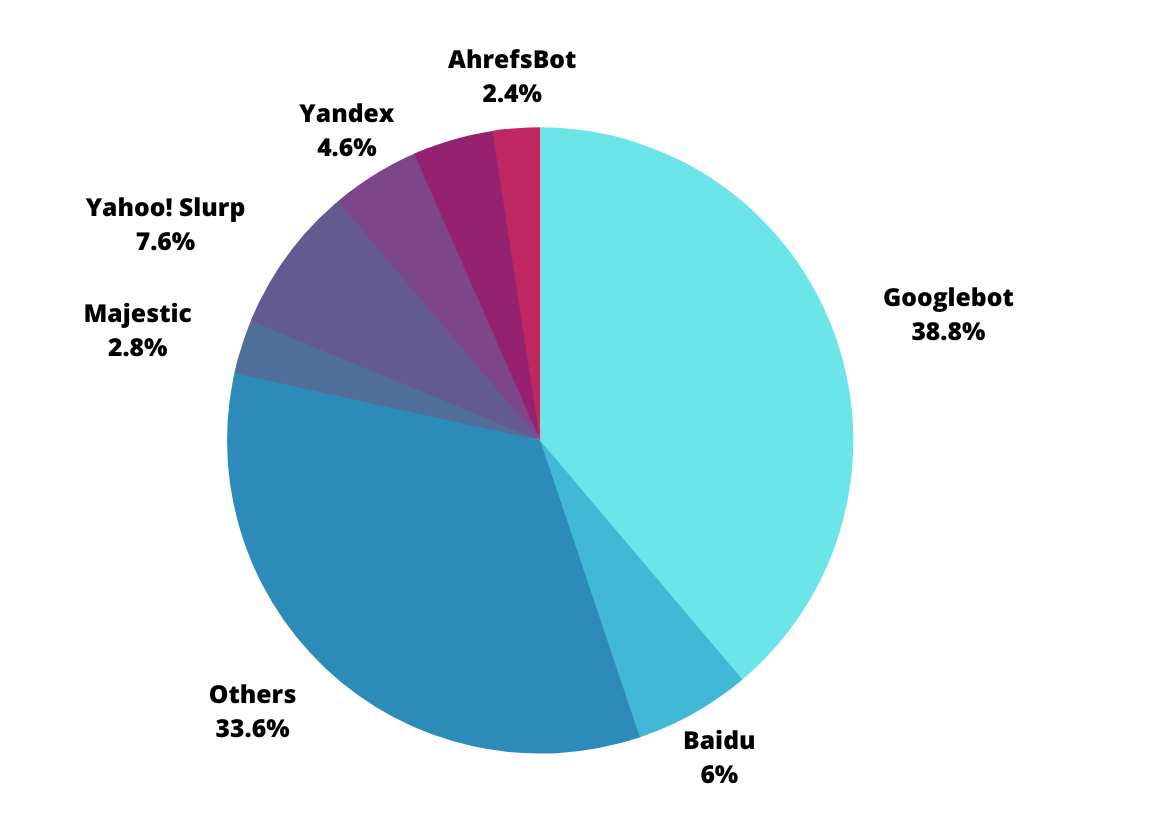

Ce script analyse les logs d’accès à un serveur web, identifie les activités des bots en fonction de leurs agents utilisateurs, compte le nombre de requêtes effectuées par chaque bot, et enregistre les dates de la première et de la dernière requête pour chaque bot dans un fichier CSV de sortie pour une représentation détaillée des interactions entre votre site et les robots des moteurs de recherche. Ces informations peuvent ensuite être visualisées sous forme de diagramme en camembert.

L’analyse des logs est une étape souvent négligée mais cruciale du SEO. Elle offre une perspective unique sur la manière dont votre site est perçu par les moteurs de recherche. Avec les outils et les compétences appropriés, vous pouvez déchiffrer ces données précieuses et optimiser votre site pour un meilleur classement et une plus grande visibilité. L’avenir appartient à ceux qui écoutent, apprennent et s’adaptent.

Conclusion : Python, l’outil ultime pour l’analyse des logs

Dans le domaine du référencement naturel (SEO), l’analyse des logs de serveur constitue une étape cruciale pour comprendre et optimiser les performances d’un site web. Au cœur de cette démarche, Python émerge comme l’outil de choix pour mener à bien cette tâche complexe. Grâce à ses capacités exceptionnelles, sa flexibilité inégalée et sa simplicité d’utilisation, Python se positionne comme l’élément essentiel pour extraire des informations pertinentes, interpréter les données et exploiter efficacement les détails enfouis dans les logs de serveur.

Les patterns et expressions régulières du script permettent d’identifier avec précision les bots d’exploration, tels que les moteurs de recherche, ainsi que leurs activités sur le site. En tirant parti de ces informations, les experts SEO peuvent évaluer l’impact de chaque bot sur le site, analyser les tendances de fréquentation et prendre des décisions éclairées pour améliorer la visibilité et l’accessibilité du site sur les moteurs de recherche.

Python offre une boîte à outils puissante pour manipuler et traiter les données extraites des logs. Les fonctionnalités intégrées, telles que les dictionnaires par défaut et les opérations sur les chaînes de caractères, facilitent la création de structures de données organisées et la gestion des informations. La capacité à travailler avec des fichiers CSV simplifie l’exportation des résultats vers un format utilisable et partageable.

En somme, le choix de Python pour l’analyse des logs démontre son adaptabilité à des tâches complexes et spécialisées comme l’optimisation SEO. Les professionnels du référencement peuvent s’appuyer sur Python pour transformer des données brutes en insights exploitables, renforçant ainsi la position et la performance de leurs sites sur le vaste paysage numérique. Avec ses avantages incontestables, Python demeure l’outil ultime pour l’analyse des logs, ouvrant la voie à une meilleure compréhension des interactions entre les bots et les sites web, et permettant des améliorations stratégiques significatives.

Sources: Logs Sample, Apache

Tags:

Python SEO